Начало 2018 года ознаменовалось появлением нового жанра порнографии — пользователи сети быстро освоили современные технологии и принялись без спроса штамповать ролики с участием знаменитостей. Больше месяца Reddit активно наполнялся контентом для взрослых, но его распространение резко решили остановить. «Лента.ру» разобралась, как идея одного средненького программиста прокатилась по всему миру и почему она оказалась не такой плохой.

Что такое Deep Fake и как оно работает

Повальное увлечение подставным порно со звездами началось в декабре прошлого года. Тогда разработчик под ником deepfakes использовал возможности искусственного интеллекта, чтобы увидеть израильскую актрису Галь Гадот без одежды. По воле анонима главная героиня фильма «Чудо-женщина» даже занялась сексом со своим «сводным братом» (по крайней мере, об инцесте говорит название оригинального ролика).

Автор был настолько удовлетворен результатом, что выложил получившуюся запись в открытый доступ на популярном имиджборде Reddit. Через какое-то время на портале появились порноролики с участием Скарлетт Йохансон, Мэйси Уильямс, Тейлор Свифт и Обри Плаза. Список рос с каждым днем.

Естественно, разработчик не договаривался с голливудскими звездами, чтобы те «снялись» для него в короткометражке: скорее всего, автор скандальных роликов никогда не видел этих людей вживую. Он просто взял их фотографии и при помощи специализированных программ «наклеил» на лица настоящих порноактрис.

Deepfakes рассказал журналистам, что он — обычный программист, который увлекается машинным обучением. По его словам, созданием таких роликов может заниматься каждый, кто хоть немного понимает суть работы нейросетей. Пользователям достаточно установить бесплатный инструмент для работы с машинным обучением TensorFlow и открытую нейросетевую библиотеку Keras.

Лица звезд разработчик находил через Google-поиск или на YouTube. Мужчина обучил нейросеть на примере фейкового ролика с Гадот, а затем использовал готовый шаблон для создания других видео.

За основу своей нейросети «порнорежиссер» взял алгоритм, схожий с разработкой NVIDIA. В конце прошлого года сотрудники компании рассказали, что научились полностью видоизменять видео при помощи машинного обучения: например, превращать зимние пейзажи в летние, и наоборот. Однако представители NVIDIA отказались комментировать их потенциальную связь с создателем фейковых порнороликов.

После публикации первых поддельных видео с участием голливудских красоток формат фейкового порно тут же оброс огромным количеством фанатов: всего за пару месяцев на подраздел Reddit подписались более 90 тысяч человек. В связи с такой популярностью модераторы сайта составили список правил, среди которых встречаются довольно занимательные пункты. Например, запрещалось выкладывать ролики с лицами несовершеннолетних звезд: несмотря на всю аморальность ситуации, администрация сайта явно опасалась реакции надзорных органов. По той же причине пользователям не разрешили публиковать видеозаписи с неизвестными людьми (скорее всего, потому что те могут подать в суд).

Порно своими руками

В январе 2018 года один из пользователей Reddit под ником deepfakeapp выложил в открытый доступ простую бесплатную программу для создания фейков, сопроводив ее подробной инструкцией.

«Думаю, текущая версия приложения вполне хороша, но я надеюсь ее оптимизировать. В конце концов, я хочу улучшить его до такой степени, чтобы пользователи могли просто выбрать видео на компьютере, загрузить нейронную сеть, коррелированную с определенным лицом из общедоступной библиотеки, и поменять на ролик с другим лицом нажатием одной кнопки», — поделился deepfakeapp с журналистами The Motherboard.

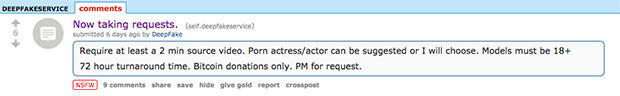

Появление простого инструмента привело к тому, что на Reddit устроили целый рынок с продажей роликов, а производство превратилось в конвейер. Созданные при помощи искусственного интеллекта ролики начали делать на заказ. Одни посетители имиджборда оставляли свои заявки с условиями и описанием работы, вторые их выполняли. Оплату «порнорежиссеры» принимали в криптовалюте. Однако даже примерные цены за создание ролика в треде они не раскрывали: все переговоры проходили в личных сообщениях.

«Делаю как минимум двухминутные ролики. Порноактрис и актеров предлагайте, либо я выберу сам. Модели должны быть старше 18 лет. Оплата только биткоинами», — оставил заявку один из подписчиков треда.

Реакция звезд

При всей популярности нового формата порно о его фальшивости узнали далеко не все. К примеру, известная хакерская группировка Celeb Jihad принялась распространять скриншоты из видео под видом реальных, «эксклюзивных» кадров.

Несмотря на всю абсурдность ситуации, опороченные голливудские звезды так и не прокомментировали происходящее. Возможно, они предпочли не привлекать лишнее внимание к этой проблеме: их реакция могла лишь усугубить ситуацию.

Фото: Reddit

Зато изобретение нового жанра охотно обсудили знаменитые актрисы из фильмов для взрослых. В интервью изданию Motherboard порноактриса Грейс Эванджелин заявила, что привыкла к бесплатному распространению роликов, но поддельное порно — это что-то абсолютно новое в индустрии.

«В подобных случаях всегда важно помнить о согласии. Создание фальшивых сексуальных сцен с участием звезд не требует их согласия. Это неправильно», — объяснила свою точку зрения Эванджелин.

Подобного мнения придерживается и бывшая порноактриса Алии Джанин, которая проработала в индустрии более 15 лет. Экс-исполнительница рассказала, что появление фейковых видео — очень тревожный знак, потому что подобные ролики выражают полное неуважение к порноактрисам и голливудским звездам, а также к женщинам в целом.

Вопрос законности

Юристы уверены, что накладывать лица звезд на настоящих порноактрис, а затем выкладывать результат в сеть — мягко говоря, плохая идея. Все участники фейковых сексуальных сцен имеют право подать на распространителя в суд за нарушение закона «О защите данных». Причем они выиграют дело, если докажут, что ролики нанесли вред их репутации. Также прокуроры могут признать фальшивые видео формой харассмента.

«Такое деяние, вероятно, будет равносильно незаконному вторжению в частную жизнь конкретной знаменитости, так как подобные видео вызывают серьезное беспокойство жертв», — прокомментировал проблему юрист Саймон Майлз. Специалист добавил, что создание фейковых эротических роликов также может быть квалифицировано как незаконная обработка персональных данных знаменитостей.

К слову, похожие истории уже случались. В сентябре 2016 года британская актриса Эмма Уотсон при помощи адвокатов добилась удаления слитых в сеть интимных снимков с порносайта Celeb Jihad. Несмотря на то что хакеры просчитались с публикацией реальных фото обнаженной девушки, суд также может встать на сторону тех знаменитостей, которые стали жертвами искусственного интеллекта, уверены эксперты.

Пока о готовящихся исках публике неизвестно, некоторые распространители поддельной порнографии прислушались к словам юристов. В начале февраля в СМИ появилось сразу несколько сообщений о том, что крупные ресурсы начали блокировать «голливудскую» эротику.

Первым избавиться от спорного контента решили руководители крупного гиф-сервиса Gfycat. Они единовременно удалили все фото и видео с невольными участницами, а также назвали подобный контент «нежелательным».

Затем к ним присоединились представители Pornhub. Они объяснили, что фейковое порно больше не появится на ресурсе, потому что звезды не давали согласие на такие «эксперименты» с их лицами. Twitter просто заблокировал все аккаунты, где публиковались видео, изображения или ссылки на порноролики.

После того как крупнейшие сайты объявили бойкот роликам, прервать молчание пришлось и руководству сайта Reddit, на страницах которого и процветал разврат с голливудскими актрисами. Площадка изменила правила и заблокировала как оригинальный подраздел Deepfakes, так и его многочисленные клоны.

«Мы обновили политику нашего сайта в отношении недобровольной порнографии и неприемлемого контента с участием несовершеннолетних. Сообщества, ориентированные на этот контент, и пользователи, которые публикуют такой контент, будут заблокированы на сайте», — заявили представители имиджборда.

Правда, приложение пользователя deepfakeapp до сих пор доступно на Reddit. Это значит, что любой желающий сможет скачать его и поэкспериментировать с возможностями нейросетей.

Хватит о сексе

Если отбросить всю неэтичность ситуации с огромным количеством поддельного порно, авторы фейковых роликов серьезно популяризовали технологию машинного обучения. О принципах работы нейросети узнало огромное количество людей, которые уже начали экспериментировать с бесплатными инструментами от Google.

Некий разработчик показал, как с помощью простого алгоритма можно убрать усы с лица человека на видео. В качестве примера программист использовал кадры со съемок фильма «Лига справедливости», где одному из героев в исполнении Генри Кавилла при помощи спецэффектов замазывали растительность на лице.

Домашний компьютер за несколько часов справился с задачей лучше, чем режиссеры монтажа из Warner Brothers за несколько месяцев. В будущем кинокомпании смогут взять этот алгоритм на заметку: например, чтобы использовать образы умерших актеров в новых картинах. (Создатели фильма «Изгой-один» задействовали слегка устаревшую технологию CGI, чтобы «оживить» на экране скончавшуюся актрису Кэрри Фишер. Многие фанаты саги остались недовольны результатом.)

Кроме того, люди используют эту технологию просто для веселья. В конце января в сети начался флешмоб: пользователи вставляли лицо Николаса Кейджа буквально во все легендарные фильмы, которые только могли вспомнить. Вероятно, выбор пал именно на Кейджа, поскольку он давно стал любимчиком интернет-публики.

Стоит отметить, что созданная пользователем Reddit программа может стать серьезным оружием в информационных войнах. Уже сегодня у людей есть возможность умело подтасовывать данные при помощи нейросетей. Это доказал ролик, на котором лицо Гитлера «наклеили» на президента Аргентины Маурисио Макри.

Однако deepfakes никакой проблемы в этом не видит. По его словам, популяризация инструментов машинного обучения так или иначе помогает технологии эволюционировать.

«Любая технология может использоваться с плохими намерениями, и это невозможно остановить. Я не думаю, что участие обычных людей в исследовании машинного обучения является чем-то плохим», — считает разработчик.